Der Wunsch, Daten als Bilder auf ein Display zu bringen, beschäftigt die Entwickler schon viel länger als man gemeinhin meint. Es begann mit dem Oszilloskop, der Schwingungen in Form von Kurven aus Lichtpunkten darstellt. Bis zu hochaufgelösten, lebensechten Bewegtbildern auf dem Computerbildschirm war es aber ein weiter Weg, der sich in drei Etappen einteilen lässt. Am Anfang stand die monochrome Pixelgrafik, es folgte die mehrfarbige Ausgabe von Foto, und heute bringen Games Szenen auf den Screen, die sich kaum noch von echten Videos unterscheiden.

Dass eine stinknormale CPU mit derlei Grafiken überfordert sind, wurde schon Ende der Siebzigerjahre im Hause Apple erkannt. Also entwickelte man einen Grafikchip, dessen einzige Aufgabe es war, die Pixel auf dem Bildschirm entsprechend den eingespeisten Vorlagen anzusteuern. Heute finden sich in dezidierten Games-Maschinen hochgezüchtete Adapter, die teilweise mehr Rechenpower haben als der ganze Rest des Computers, in dem sie Dienst tun, zusammen. Diese Mega-Power-Grafik-Engines sind sündhaft teuer und bisweilen kaum zu kriegen.

Aber, beginnen wir am Anfang, nämlich beim Monitor mit Kathodenstrahlröhre. Eine solche Braun’sche Röhre erzeugt einen gebündelten Elektronenstrahl, der durch magnetische oder elektrische Felder abgelenkt werden. Trifft der Strahl auf eine Leuchtstoffschicht, sieht man vorne auf dem Glas eines Bildschirms einen hellen Punkt. Füttert man die Ablenkeinheit mit Daten, zum Beispiel denen einer Sinuskurve, lässt sich die Schwingung darstellen – das liegt daran, dass die fluoreszierende Schicht nachleuchtet, ein Punkt als auch noch eine Zeitlang sichtbar bleibt, nachdem der Elektronenstrahl schon woanders ist. Das Prinzip ist die vektorielle Ansteuerung.

Basis für die Anzeige ist ein Koordinatensystem, das angibt, in welcher Höhe und auf welcher Breite der Bildpunkt angezeigt werden soll. Mit der Erfindung der Bildröhre für Fernsehgeräte haben kluge Forscher dieses Prinzip verfeinert. Nun wirft die Röhre den Bildpunkt mit hoher Frequenz (ursprünglich 50, später 100 Hz) zeilenweise auf die Leuchtschicht. Damit das gleichmäßig funktioniert, sorgt ein Zeilengenerator für eine gleichbleibende Hochspannung. Um das menschliche Auge zu überlisten und ruckfreie Bewegtbilder zu erzeugen, werden zeilenweise Halbbilder erzeugt, die sich zum eigentlichen Bild ergänzen. Dies ist die zeilenweise Ansteuerung.

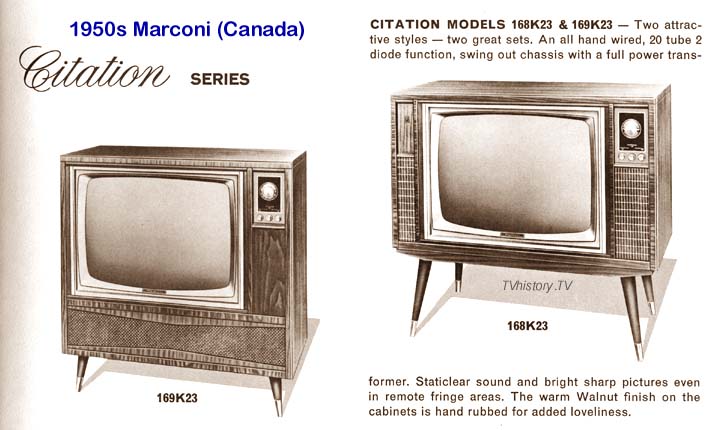

Die Computermonitore mit Kathodenstrahlröhren entwickelten sich tatsächlich aus Fernsehgeräten. In der Frühzeit der Homecomputer konnten viele Rechner einen solchen Fernseher tatsächlich auch als Monitor benutzen. Dabei ist die zeilenweise Ansteuerung für die Darstellung von Bilddaten gar nicht so gut geeignet. Der Fortschritt fand deshalb weniger auf der Hardwareseite (hier verlief die Entwicklung annähernd parallel) als vielmehr bei der Software statt, die fest in spezialisierte Grafikchips implementiert wurde.

Auch wenn von echter Rastergrafik noch nicht die Rede sein konnte, ließen sich so einzelne Bildpunkte auf dem Monitor ansteuern. Weil schon die frühen Apple-Computer und auch der Commodore 64 mit Speicherbereichen für die Bildschirmausgabe arbeiteten, ließen sich die gewünschten Bilder dort errechnen, um sie anschließend auf den Monitor zu projizieren. Das Prinzip entstand jedoch im Umfeld der Arcade-Maschinen, also der Konsolen in Spielhallen. Erfindungen wie „Sprites“, die für realitätsnahe Bewegtbilder enorm hilfreich waren, sorgten dafür, dass wiederverwendbare Objekte im Grafikspeicher abgelegt und von dort aus nach Belieben in die Ausgabegrafik integriert werden konnten.

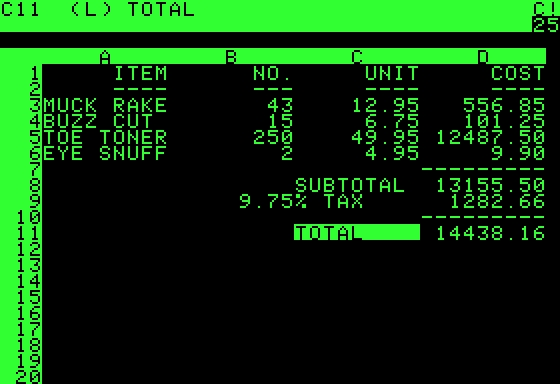

Wichtiger war aber zunächst die Darstellung von Zeichen für die Textausgabe. Jeden Buchstaben einzeln mit dem Elektronenstrahl zu “malen”, erwies sich rasch als der falsche Weg. Stattdessen entwickelte man Bausteine, in denen die Buchstaben, Ziffern, Satz- und Sonderzeichen als Rastergrafiken abgelegt waren. Sollte ein großes A erscheinen, musste keine CPU mehr das Muster erreichen, sondern nur noch abrufen. Das waren die Anfänge der Rastergrafik.

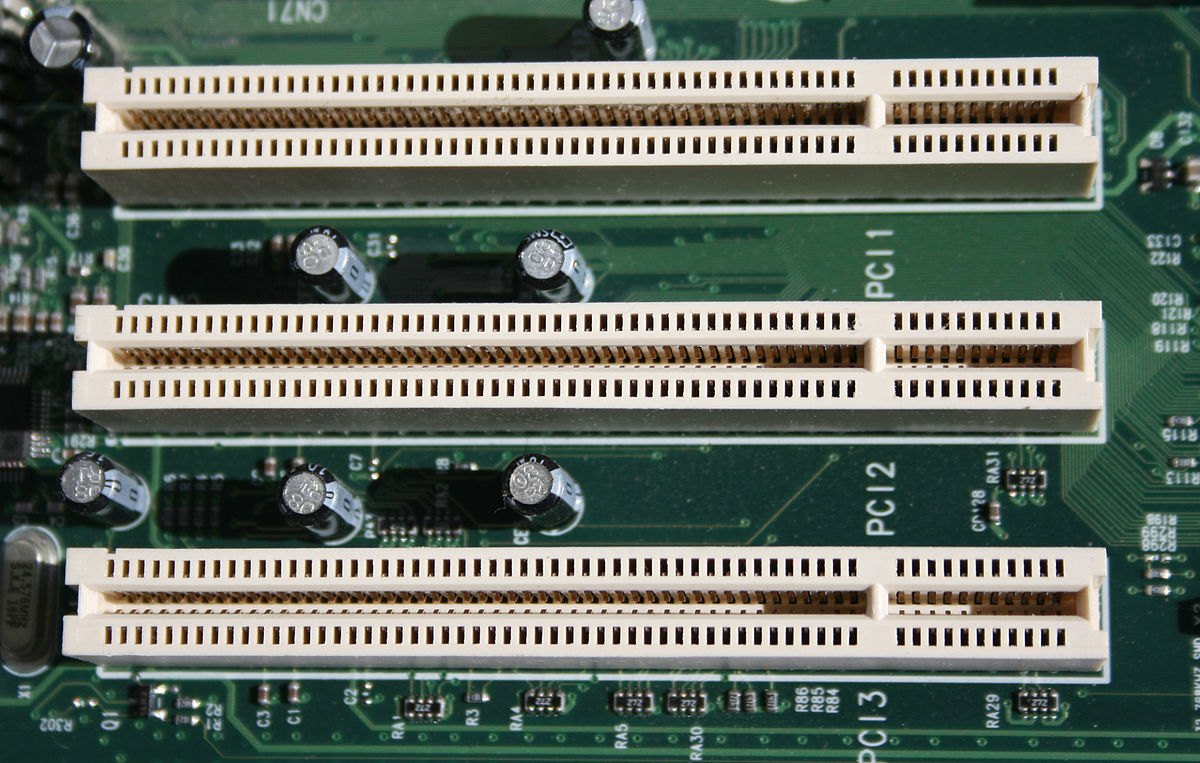

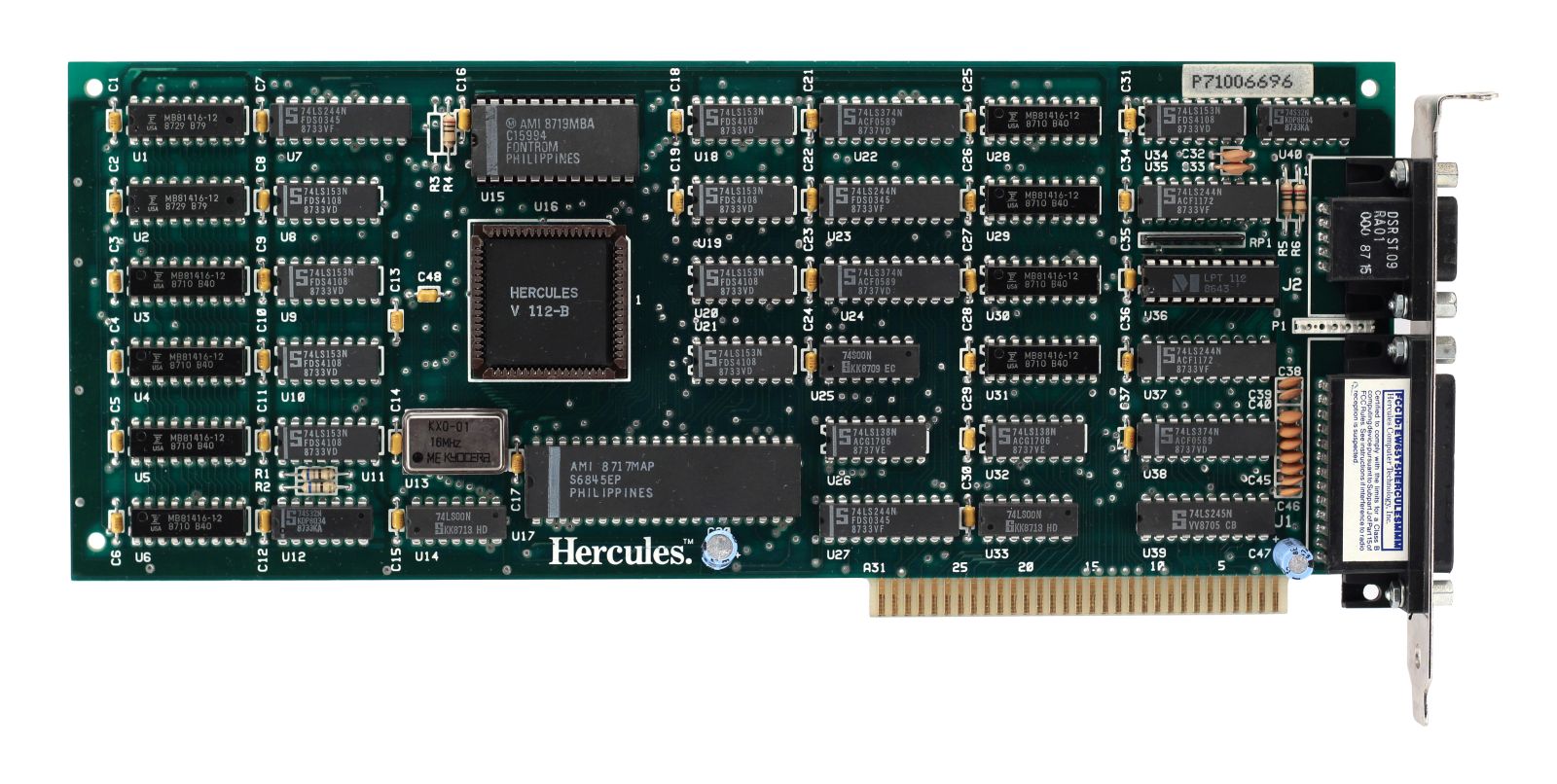

In den Zeiten der Steckplätze auf Mutterplatinen, ein Prinzip, das in der Computerei selbst recht alt ist, aber erst mit dem IBM PC im Bereich der persönlichen Computer salonfähig wurde, kamen dann die ersten Grafikkarten auf den Markt. Deren einzige Aufgabe war (und ist) es, die von der CPU errechneten Daten aufzubereiten, um den Monitor so anzusteuern, dass er diese Daten als Text oder Bild ausgeben konnte. War das alles bis weit in die Achtzigerjahre noch monochrom, brachten die rasanten Entwicklungen der Betriebssysteme einerseits und der Computermonitore andererseits Farbe ins Spiel.

Vorreiter waren hier die Homecomputer, die ja von Beginn an immer auch Spielmaschinen waren. Und angesichts der Arcade-Maschinen der späten Siebzigerjahre mit ihren knallbunten Grafiken, wollte man sich auch zuhause nicht mit monochromen Pong zufrieden geben. Aber erst mit der PC-Welt begann die Standardisierung der Grafikkarten, also die festgelegten Spezifikationen für die Auflösung und die Farbtiefe. Im Umfeld von MS-DOS und Windows hielten die Betriebssysteme noch halbwegs Schritt, weil aber die Programmentwickler – wieder vor allem die im Gaming-Sektor – immer höhere Ansprüche an die Grafik stellten, wurden die Entwickler der Grafikkarten ständig vorangetrieben.

Zumal die 16-Bit-Computer dieser Ära jeder PC-Grafikkarte meilenweit voraus waren – insbesondere der Atari ST und der Commodore Amiga. Gerade das Amiga-Team ging einen Weg, der die Möglichkeiten für die Grafik- und Videodarstellung drastisch verbesserte: Man entwickelte einen Chipsatz, dessen Aufgabe es ausschließlich war, Bild und Ton von maximaler Qualität zu erzeugen. Während in der ersten Phase der Computergrafikhistorie vor allem die Spiele Treiber der Entwicklung waren, übernahmen die Grafikdesigner diese Rolle, weil sie endlich Fotos in bester Qualität auf den Bildschirm bringen und vorher bearbeiten wollten.

Es gab aber zwei andere Branchen, die in den frühen Neunzigern die nächsten Quantensprünge in der Computergrafik auslösten: die Rüstungs- und die Pornoindustrie. Beides Sektoren, deren Insassen ein erhebliches Interesse an möglichst großen, möglichst hochaufgelösten Fotos hatten. Die ersten Grafiksprachen (zum Beispiel OpenGL) entstanden im militärischen Umfeld, die grundlegenden Designs von Grafik-Engines wurden ebenfalls im Bereich der Rüstung entwickelt.

Dieses Spiel wiederholte sich umgehend auf dem Gebiet der Videos, die noch höhere Ansprüche an Rechengeschwindigkeit und Speicherkapazitäten stellten. Als ab etwa 1998 die Bandbreiten im Internet explosionsartig wuchsen, wurden aus Stunden, die der Download eines Erotikfilmchens brauchte, nur noch Minuten. Sich Videos auf dem Computer anzuschauen, wurde Mainstream. Parallel dazu erreichten auch Computerspiele neue Höhen. Ende 1993 kam mit Doom einer der ersten 3D-Egoshooter auf den Markt, in dem sich der Spieler in Echtzeit durch dreidimensionale Räume bewegen konnten – Freunde des Gamings, aber auch Computerfreaks waren geflasht (und das US-Militär förderte insgeheim die Fortschritte dieser Technologie im Hinblick auf seine Vorstellung vom Krieg der Zukunft…).

Das, was man früher schlicht „Computerspiel“ nannte, hat sich im Verlauf der Nuller-, mehr noch der Zehnerjahre vom Rest der Computerei fast vollständig abgekoppelt. Ernsthafte Hobby-Gamer, mehr noch die professionellen E-Sportler verfügen über spezialisierte Desktop-Rechner, die in jeder Hinsicht auf den Einsatz bei Games optimiert sind; die „normale“ PC-Arbeit findet dann am Notebook oder Tablet statt.

Und je realistischer, vielschichtiger, schneller und interaktiver diese Highend-Games wurden, desto größer wurden die Ansprüche an Grafikkarten. Ja, inzwischen sind Grafikkarten für Desktop-PCs, die noch über Steckplätze verfügen, fast durchgehend aufs Spielen hin optimiert. Dass sie sich auch hervorragend für die Bild- und Videobearbeitung eignen, ist ein Nebeneffekt. Drei, vier Hersteller dominieren den Markt. Vorreiter war die Firma Nvidia mit der Geforce-Reihe. Im Prinzip handelt es sich bei den aktuellen Highend-Grafikkarten um „richtige“ Computer mit einer GPU (Graphic Processing Unit) bis zu 128 Gigabyte RAM und einer Reihe von hochspezialisierten Chips für Teilaufgaben der Bilderzeugung.

Die Spitzenmodelle kosten teilweise mehr als 2.500 Euro und werden in kleinen Stückzahlen produziert, sodass es lange Wartelisten für Käufer gibt. Dies auch verschärft durch den aktuellen (Stand: April 2022) Mangel an Chips.

Seit knapp 10 Jahren spielen solche hochgezüchteten Grafikkarten auch beim Mining von Kryptowährungen eine Rolle. Bei Bitcoin kann nur der einen neuen Block in der Kryptochain anlegen, der eine hochkomplexe Rechenaufgabe als erster löst. Etwa ab 2014 kamen pfiffige Nerds auf die Idee, für diese Berechnungen Grafikprozessoren zu verwenden, deren reale Rechengeschwindigkeit oft deutlich höher ist als die der Hauptprozessoren. Dieser Trend löste einen Run auf Highend-Grafikkarten aus und führte schon um 2016 herum zu ersten Lieferschwierigkeiten. Gerade in China entstanden regelrechte Mining-Fabriken mit Hunderten Rechner mit jeweils zwei, vier oder gar sechs Grafikkarten, die rund um die Uhr liefen – und Unmengen Strom verbrauchten.

In dem Maße, in dem die Betreiber der Blockchains für Kryptowährungen auf andere Mining-Verfahren umstellen, beruhigt sich der Markt wieder, und ambitionierte Gamer, die nicht immer das Neuste, Beste und Schnellste brauchen, sind mit den Grafikkarten der vorletzten Generation immer noch gut bedient; die sind in ausreichenden Stückzahlen und zu vernünftigen Preise neu oder gebraucht zu haben.