Dieser Computerbuchverlag war auch mal eine große Nummer. Damals in den goldenen Zeiten der Homecomputerei, als sich in Deutschland drei Verlage bekämpften. Ja, ein anderes Verb passt kaum, denn die Rivalitäten zwischen Markt+Technik, Data Becker und eben Sybex waren oft äußerst emotional geprägt. Zumal es gleichzeitig auch um Animositäten zwischen den Verlagsstandorten München und Düsseldorf ging. Die Bayernmetropole verstand sich als DIE Computerhauptstadt der Bundesrepublik und ließ diese Haltung mit einiger Arroganz raushängen. Diese Sache ging so weit, dass sich in Düsseldorf ein Stammtisch für Computerbuchautoren und -journalisten gründete, der zur Computermesse Systems 1989 in München (mit finanzieller Unterstützung von Vobis-Boss Theo Lieven) die schärfste Party der Messewoche in einer der angesagtesten Clubs in Schwabing veranstaltete. Während sich Data Becker und Markt+Technik ziemlich lautstark duellierten, kam Sybex eher still daher. Fast vergessen (24): Was wurde eigentlich aus dem Computerbuchverlag Sybex? weiterlesen

Archiv der Kategorie: Ge-dacht

Das ist eher das philosophische bei uns. Lautes oder verschriftliches Denken hat hier seinen Platz: ob nun nachdenken, vorausdenken oder mitdenken ist egal

Die Digisaurier machen Winterpause…

Man kann ja nicht ständig mit digitalen Devices hantieren. Besonders nicht, wenn Weihnachten vor der Tür steht und nach elektronischen Geschenken ruft. Und auch der Winter nach anderen Aktivitäten ruft. Deshalb legen wir Digisaurier eine Winterpause ein. Ab dem 1. Februar 2024 sind wir wieder da – reich beschenkt und gut gekühlt und voller Ideen für neue Artikel. Bis dahin: Habt einen schönen Sommer!

Ranking der Chip-Hersteller: Ist Nvidia das neue Intel?

Um die Eingangsfrage kurz und knapp zu beantworten: Ja. Wobei entgegen aller Wahrnehmung über die Jahrzehnte Intel nie so wichtig war wie es Nvidia heute ist. Und das hat, na klar, etwas mit dem Hype-Thema unserer Zeit zu tun: der Künstlichen Intelligenz (kurz: KI, oder englisch: AI). Wobei es schon ein wenig flapsig ist, AI als Hype zu betrachten, denn Hypes kommen und gehen, und die Künstliche Intelligenz ist hier, um zu bleiben. Die Möglichkeiten selbstlernender Systeme, da sind sich die Fachleute einig, werden unsere Welt stärker verändern als beispielsweise der persönliche Computer oder das Internet. Denn die KI wird in sämtliche Wirtschafts- und Lebensbereiche eingreifen und tut das schon heute. Ranking der Chip-Hersteller: Ist Nvidia das neue Intel? weiterlesen

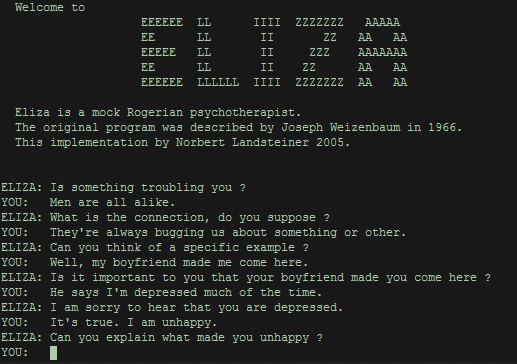

Eliza, Q&A, ChatGPT und die anderen – keine Angst vor sprechender KI

Schon lange nicht mehr hat eine Innovation der Informationstechnologie so viel Echo in den allgemeinen Medien erfahren wie die schreibende KI-Maschine ChatGPT. Leider erklären die Journalist:innen, die das Thema verbreiten, so gut wie nie, worum es sich tatsächlich handelt und wie dieser scheinbar intelligente Chatbot funktioniert. Altgediente Digisaurier können da helfen, denn sie haben schon in den Siebzigerjahren mit ELIZA gechattet. Eliza, Q&A, ChatGPT und die anderen – keine Angst vor sprechender KI weiterlesen

Wo sind all die Daten hin? Ein Requiem für verlorengegangene Mails, Texte und Fotos

Haben wir nicht alle schon einmal Daten verloren, die wir für unverzichtbar hielten? Mailarchive, besonders wichtige Texte und digitale Fotos, die uns als Erinnerungsstützen dienten? Bestimmt. Und meistens waren wir selber schuld… Zeit also, ein Requiem für all die verlorengegangenen Dateien zu komponieren. Wo sind all die Daten hin? Ein Requiem für verlorengegangene Mails, Texte und Fotos weiterlesen

Fast vergessen (10): Was wurde eigentlich aus Atari? – Part III

Das Unternehmen Atari kam aus der Welt der Videospiele und starb in dieser Welt. Was immer Jack Tramiel und seine Untergebenen bewegt haben mag, praktisch die kompletten Finanzreserven in die Entwicklung einer mit einem Motorola 68000er angetriebenen Spielkonsole zu stecken, ist ein bis heute ungelöstes Rätsel. Denn zu allem Überfluss entwickelte man selbst (mit Hilfe von externen Spezialisten) einen 64-Bit-Grafik- und einen 32-Bit-Soundchip. Der Jaguar kam 1993 auf den Markt und wurde ein Flop: Irgendwas zwischen 150.000 und 250.000 Stück wurden in den knapp drei Jahren seiner Existenz abgesetzt. Und als der Jaguar 2 als Konkurrent zu Sony Playstation, Sega Saturn und Nintendo 64 entwickelt wurde, war der Markt zwischen Sony und Nintendo praktisch schon aufgeteilt. Weil Tramiels Laden de facto pleite war, musste er der Übernahme durch JTS zustimmen, mit dessen Gründer Jugi Tandon keine wirkliche Freundschaft verband. Fast vergessen (10): Was wurde eigentlich aus Atari? – Part III weiterlesen

Fast vergessen (10): Was wurde eigentlich aus Atari? – Part II

Und es blieb kompliziert. Über die Gründe, warum Nolan Bushnell Atari 1976 an Warner Communications verkaufte, gibt es verschiedene Geschichten. Die Situation war jedenfalls so, dass das Geschäft mit den Arcade-Maschinen nicht mehr so gut lief wie in den ersten Jahren und dass Atari mit den Spielkonsolen für den Hausgebrauch nicht sehr viel Geld verdiente. Man hätte den Verkaufspreis deutlich erhöhen müssen, um bei der doch recht aufwändigen Fertigung ausreichende Profite erzielen zu können. Witzigerweise wirkten die späteren Apple-Gründer Steve Jobs und Steven Wozniak 1975 kurze Zeit für Atari, und letzterer entwickelte preisgünstigere Herstellungsverfahren, die aber nur teilweise umgesetzt wurden. Fast vergessen (10): Was wurde eigentlich aus Atari? – Part II weiterlesen

Fast vergessen (10): Was wurde eigentlich aus Atari? – Part I

Es ist kompliziert. Denn die Geschichte des Namens (nicht der Firma) Atari steht stellvertretend für die chaotischen Entwicklungen der digitalen Dinge für Jedermann in den Siebziger- und Achtzigerjahren. Alles änderte sich schnell. Was heute noch innovativ und angesagt war, verschwand am nächsten Tag in der Versenkung der elektronischen Irrwege. Besonders kurvenreich verlief die Historie der Computerspiele, und Nolan Bushnells Atari war und stellt bis heute einen zumindest spannenden Faktor darin dar. Fast vergessen (10): Was wurde eigentlich aus Atari? – Part I weiterlesen