Könnte sein, dass der 20. August 2022 ein historischer Tag war. Zum ersten Mal zeigte die Tagesschau in der 20-Uhr-Ausgabe eine OpenStreetMap-Karte als Illustration zu einer Nachricht. Die Karte hat also Geodaten des freien Projekts OpenStreetMap (OSM) als Basis genutzt. Wer regelmäßig Wikipedia nutzt, kennt die aus OSM-Daten erzeugten Karten sowieso, denn die beiden Projekte kooperieren. Nur Ilse und Horst Normaluser, die hängen immer noch bei Google Maps fest. Oder wer voll und ganz im Apple-Kosmos lebt, der nutzt natürlich Apple Maps. Es soll sogar Menschen geben, deren Leib-und-Magen-Kartendienst Bing Maps heißt und von Microsoft kommt. OpenStreetMap – die Mitmach-Alternative zu Google Maps weiterlesen

Archiv der Kategorie: Ge-sehen

Ob einen Film, eine Sendung, ein Online-Video oder auch irgendwas auf der Straße, bei einem Besuch oder dergleichen was man für diese Seite mal beschreibt.

Kleine Weltgeschichte der elektrischen Musik (Teil 3) – Software statt Röhren und Transistoren

Der entscheidende Satz zum Übergang der Musik von der Elektrizität, von den Röhren und Transistoren in die digitalisierte Neuzeit lautet: „Alles, was man mit Schaltungen aus elektrischen und elektronischen Bauteilen zusammensetzen kann, kann man auch in Software nachahmen.“ Nun gilt diese Aussage beileibe nicht nur für die akustische Kunstform, sondern für fast alle Gebiete, in denen es etwas zu steuern und zu berechnen gilt. Bei der Musik liegt es aber vor allem daran, dass die Menschen schon immer – neben der eigenen Stimme – Instrumente benutzt haben, um Klang zu erzeugen; es führt eine direkte Linie von der Knochenflöte des Neolithikums bis zum modernen, digitalen Synthesizer. Einen Teil dieses Weges haben wir im ersten und zweiten Teil unserer kleinen Weltgeschichte der elektrischen Musik beschrieben. Nun geht es zum abschließenden Kapitel dieser Historie, denn irgendwie technologisch geartete Innovationen des Musikmachens sind kaum zu erwarten. Kleine Weltgeschichte der elektrischen Musik (Teil 3) – Software statt Röhren und Transistoren weiterlesen

Kleine Weltgeschichte der elektrischen Musik (Teil 2) – Von Oszillatoren und Synthesizern

Der erste Teil unserer kleinen Weltgeschichte der elektrischen Musik beschrieb den Weg von der Mechanik bis zur Elektrik. Dieses Mal geht es um den Übergang zur Elektronik und in der Folge zur Digitalisierung. Wobei beides – wie bei fast allem, bei dem der Computer mitspielte – aufeinander aufbaut. Grundlage aber bildeten die archaischen Formen der elektrischen Klangerzeugung, die wir in der ersten Formen im Umfeld der Telegrafie und der Telefonie kennengelernt haben – allen voran der Oszillator. Solche physikalisch beschriebenen Systeme erzeugen Schwingungen – das klassische Uhrwerk ist solch ein Oszillator. Mechanische Oszillatoren sind in der Regel gedämpfte Schwingungserzeuger; wird keine Energie von außen zugeführt, nimmt die Amplitude immer mehr ab, bis die Schwingungen zum Stillstand kommt.

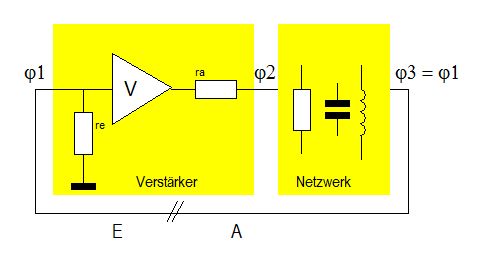

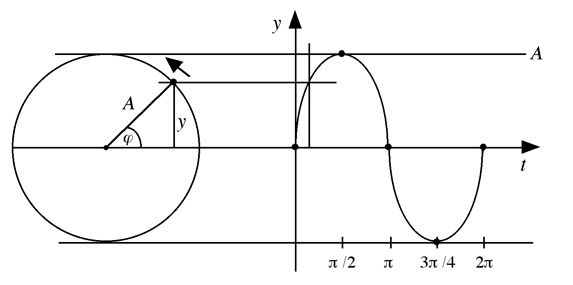

Die grundlegende Erfindung für jegliche Art elektrischer Klangerzeugung ist eine Schaltung, die gleichbleibende (ungedämpfte) Schwingungen erzeugt so lange Strom anliegt. Soll der Output eines Oszillators steuernd genutzt werden, handelt es sich um einen Signalgenerator. In der Musik kommen zur Tonerzeugung (Nicht Klangerzeugung!) vor allem Sinus- und Sägezahn-Generatoren zu Einsatz. Bei einem Sinusgenerator steigt die Spannung gleichmäßig bis zum definierten Höchstwert an, um dann ebenfalls gleichmäßig auf den Nullwert zu sinken … und so weiter. Eine Sägezahnschwingung liegt vor, wenn die Spannung linear bis zum Höchstwert steigt und dann sofort wieder auf Null sinkt. Neben der Sinus- und der Sägezahn-Schwingung können noch Dreieck- und Rechteckschwingung mit einem elektrischen Oszillator erzeugt werden. Bei einer Rechteck-Schwingung steigt die Spannung ohne Zeitverzögerung von Null auf den Maximalwert, verharrt dort eine definierte Zeitlang, um dann ohne Zeitverzögerung wieder auf Null zu fallen. Die Dreieck-Schwingung läuft so ab, dass die Spannung linear ansteigt, um vom Höchstwert wiederum linear abzusteigen.

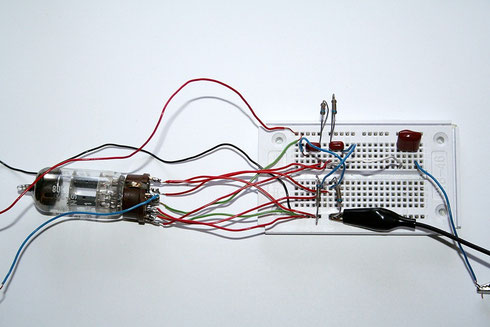

Einfache und relativ ungenaue Oszillatoren lassen sich ganz simpel aus Spulen und Kondensatoren aufbauen – die Türklingel früherer Jahre war ein solcher Oszillator, der einen Klöppel in Schwingungen versetzte, der wiederum auf eine Glocke schlug. Deutlich gleichmäßigere Schwingungen liefern Elektronenröhren und natürlich deren technologischen Nachfolger, die Transistoren. Tatsächlich wurden in den ersten Elektrophonen, also Musikinstrumenten, bei denen für die Klangerzeugung keinerlei Mechanik eingesetzt wird, solche „Radioröhren“ eingesetzt, die entweder Sinus- oder Dreiecksschwingungen erzeugen können.

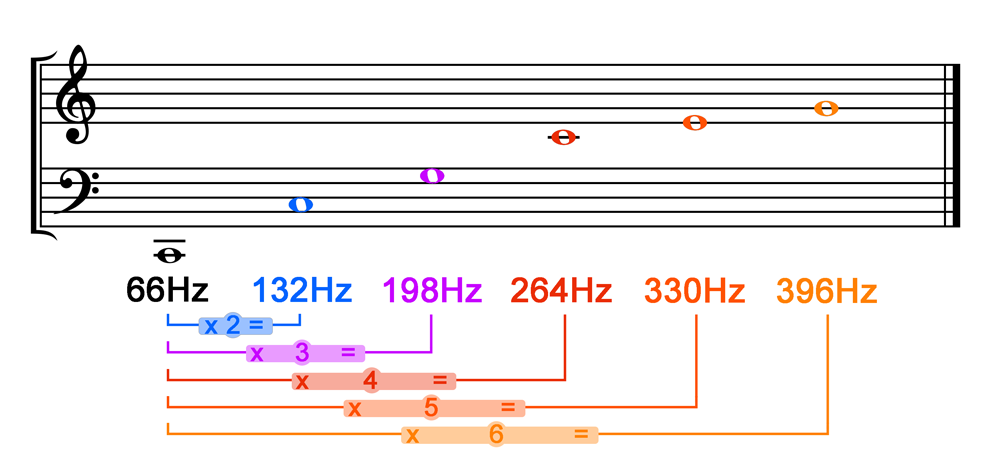

Als harmonische Schwingung gilt die Sinusschwingung, die durch zwei Werte beschrieben werden kann: die Amplitude und die Periodendauer bzw. die Frequenz, die den Umkehrwert der Periodendauer darstellt. In Bezug auf Töne, die durch einen Sinusoszillator erzeugt werden, nimmt das Ohr eine größere Amplitude als größere Laustärke war und eine höhere Frequenz als größere Tonhöhe. Das menschliche Ohr kann im Idealfall Frequenzen von 20 Hz bis 20.000 Hz wahrnehmen, wobei die Einheit Hz (Hertz) die Anzahl der Schwingungen pro Sekunde angibt. Ein Ton, der per Sinusoszillator erzeugt wird, sich zwischen den genannten Frequenzgrenzen bewegt und einen Lausprecher ansteuert, erzeugt einen durchgehend gleichbleibenden Ton derselben Höhe und Lautstärke. Zum Beispiel den Kammerton A, der mit exakt 440 Hz schwingt.

Die erste wichtige Erfindung auf dem Weg zum Synthesizer war der VCO (Voltage Controlled Oscillator). Dabei handelt es sich um einen Oszillator, dessen Frequenz durch die anliegende Spannung verändert werden kann, bei dem sich also die Tonhöhe beeinflussen lässt – zum Beispiel über einen Potentiometer in Form eines Drehknopfs oder Schiebereglers. Ganz unabhängig von diesen technischen Innovationen haben sich mehrere Menschen auf der Welt mit der Analyse von Klang auseinandergesetzt. Der erste war ein gewisser Jean Baptiste Fourier, ein französischer Physiker und Mathematiker, der neben ganz alltagspraktischen Dingen auch die Fourier-Transformation entwickelt, eine Methode, mit der man einen Klang in alle enthaltenen Sinustöne zerlegen kann.

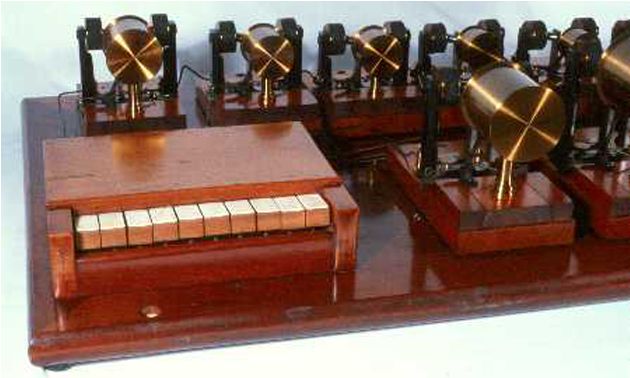

Damit wird es möglich, die Klangfarben verschiedener Instrumente zu analysieren. So wurden auch das ganze Spektrum der Obertöne entdeckt, also der Schwingungen, die neben dem Grundton entstehen. Damit befasste sich der Arzt und Physiker Helmut von Helmholtz während er sich mit den Vokalen in der menschlichen Sprache beschäftigte. Singt man die Vokale A, E, I, O, U in gleicher Lautstärke und Tonhöhe, klingen sie doch unterschiedlich. Das liegt an den Obertönen, die je nach Lautbildung entstehen. Helmholtz fand heraus, dass man durch die Manipulation der Obertöne jedes Instrument täuschend nachahmen kann. Als Beispiel baute er seinen Helmholtz-Synthesizer, bei dem elektrisch angeregte Stimmgabeln die ersten zehn Obertöne zu einem Grundton spielen konnten. Dies war der erste ernsthafte Versuch der Klangsynthese.

Bis hierher wissen wir nun, wie man Töne synthetisch erzeugen und mit Obertönen ausstatten kann, um Klänge zu generieren – zum Beispiel um das Klangbild eines klassischen, nicht-elektrischen Musikinstruments zu imitieren. Musik aber ist das Zusammenspiel von Klängen, Muszieren besteht vor allem aus dem Modifizieren von Klängen. Nun kommen in der Natur reine Sinustöne nicht vor, sodass natürlich klingende Klänge aus synthetischen Tönen elektronisch bearbeitet werden müssen. Das geschieht mit Filtern, die bestimmte Frequenzen eines Tonspektrums verstärken, andere dämpfen und wieder andere ganz ausfiltern. Passend zum VCO als Tongenerator wird ein solches Filtermodul Voltage Controlled Filter (VCF) genannt.

Um aber noch näher an die gewohnten Klangfarben zu kommen oder noch mehr Möglichkeiten der Modulation synthetischer Klänge zu haben, braucht es ein weiteres Modul. Mittel der Wahl zu diesem Zweck in der elektronischen Musikerzeugung ist der Low Frequency Oscillator (LFO). Dabei handelt es sich wie beim VCO um einen tonerzeugenden Oszillator, der aber niederfrequente Schwingungen erzeugt (meist im Bereich unterhalb von 10 Hz), die das menschliche Ohr nicht wahrnimmt. Die so erzeugte Frequenz wird additiv oder subtraktiv mit dem vom VCO erzeugten Ton gemischt und verändert diesen. Ein LFO kann ganz einfach als Filter eingesetzt werden, aber in den meisten Synthesizern erzeugt er ein Vibrato oder Tremolo; beides wichtige Klangmerkmale bekannter Instrumente.

Wie Musikbeispiele der frühen Synthesizer-Jahre, also vor etwas 1970, zeigen, haben Musiker die Kombinationen aus VCO- und LFO-Modulen vor allem dazu benutzt, neue, bis dahin ungehörte Klänge zu erzeugen. Der typische „Synthi-Klang“ entstand. Weil aber Musikanten, die von der traditionellen E-, aber auch U-Musik kamen, oft keine Instrumente spielen wollten, bei denen sie die Töne durch Drehen an Knöpfen, Stöpseln von Kabeln oder Tippen auf Schalter auszuwählen hatten, verlangten sie nach einer klassischen Klaviatur – dem, was man heute ein Keyboard nennt. Und damit entstand der Bedarf nach der Modulation der sogenannten „Hüllkurve“.

Die beeinflusst den erzeugten Ton in Bezug auf den Zeitverlauf und die Lautstärke und wird bei elektronischen Instrumenten nach dem vierphasigen ADSR-Prinzip (attack time, decay time, sustain level, release time) beschrieben. Das A steht für „attack“ und definiert die Zeit, die vom Drücken der Taste bis zum Erreichen der maximalen Spannung, die am Tonerzeuger anliegt. Mit dem D wird die „decay“-Phase beschrieben; sie bemisst die Zeit, die vom höchsten Spannungslevel vergehen soll bis sie auf das Sustain-Niveau abgesunken ist. Mit dem S-Parameter („sustain“) wird festgelegt, welche Spannung anliegen soll, wenn die Taste gedrückt gehalten wird. Mit dem Loslassen der Taste beginnt die Release-Phase, in der die Spannung vom erreichten Wert wieder auf Null absinkt. Zuständig für diese Modulationen sind Hüllkurven-Generatoren.

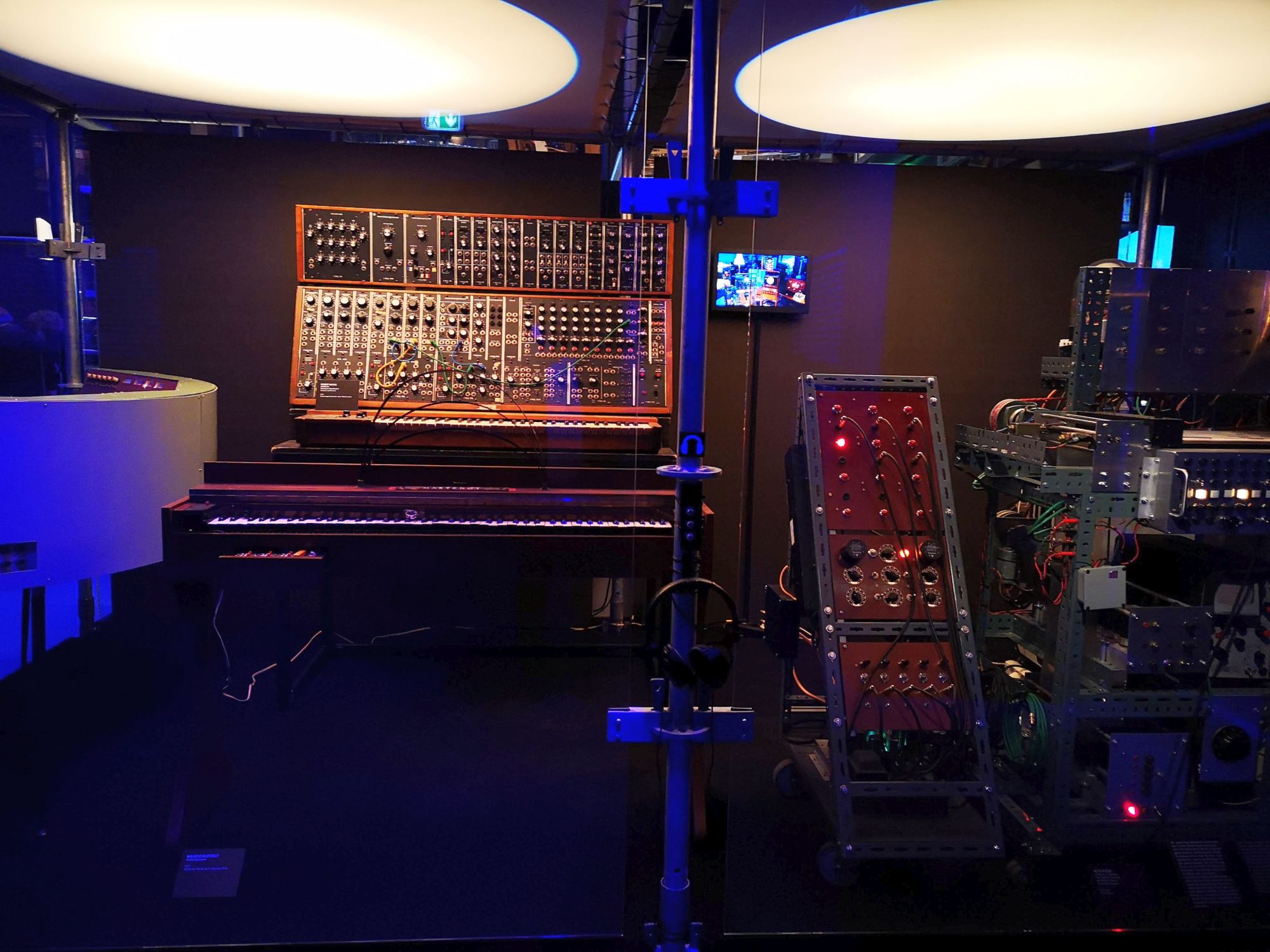

Weitere Module dienen dazu, bestimmte Soundeffekte – z.B. das von der E-Gitarre her bekannte Phasing (VCP) – zu erzielen, dienen als Verstärker (VCA) und modifizieren Töne auf verschiedenste Weise. All diese Funktionen ließen sich auch mit Elektronenröhren erzielen, aber die so aufgebauten „Synthesizer“ wie das Tellharmonium waren enorm groß und schwer und verbrauchte gigantische Mengen an Strom. Erst mit der Verwendung von Transistoren wurde der Bau brauchbarer modularer Synthesizer möglich.

Noch aus den Zeiten der Drehorgel und des elektrischen Klaviers stammt die Idee, Musik aufzuzeichnen und dann ohne menschliches Zutun abzuspielen, also Partituren zu speichern, um so ein gespieltes Musikstück reproduzierbar zu machen. Das Prinzip fand schon in der Frühzeit der elektronischen Musik der Avantgardisten Anwendung – zum Beispiel durch Speicherung der Tonabfolgen auf Lochkarten. Auf der nächsten Stufe wurden elektromagnetische Datenträger (Bänder, Platten, Disketten) benutzt, wobei es bis weit in die Siebzigerjahre keinen Standard für die digitale Notation gab. Da musste in den Achtzigerjahren erst MIDI (Musical Instrument Digital Interface) erfunden werden…

Das Device für das digitale Aufzeichnen und wieder Abspielen ist der Sequencer, das immer schon entweder ein separates Gerät war oder aber als Modul in einem modularen Synthesizer wirkte. Dabei hat sich das MIDI-Prinzip weitgehend durchgesetzt, bei dem nicht die Töne gespeichert werden, sondern die Daten, mit denen die Wiedergabe auf einem Synthesizer gesteuert wird. MIDI-Daten bestehen aus Informationen über die Tonhöhe einzelner Töne, sowie über deren ADSR-Hüllkurve, aber auch Anweisungen darüber, welches „Instrument“ der Synthi spielen soll. MIDI-Sequenzen können direkt mit einem Keyboard (auch einer Computertastatur) als Noten eingegeben oder aber nach einem ablaufenden Musikstück aufgezeichnet werden.

Während der Sequencer Partituren für die Wiedergabe auf einem anderen Sequencer erzeugt, dient ein Sampler dazu, Klangstückchen aufzunehmen, daraus Schleifen (Loops) zu bilden, die sich dann „auf Knopfdruck“ wiedergeben lassen. Dabei kann der Klang mit dem Mikrofon aufgenommen (gesprochenes Wort, Vogelstimmen, Naturklänge, aber natürlich auch Musik) oder von einem Tonträger (Band, Platte, CD etc.) gezogen werden. Mit dem Keyboard lässt sich dann jeder Schnipsel abspielen und in der Tonhöhe verändern. In der Praxis legt sich ein Synthie-Spieler ein und dieselbe Loop auf mehrere Tasten oder speichert auf mehreren Tasten jeweils ein anderes Sample – das wird dann beim Anschlag einer Taste in der gespeicherten Länge abgespielt. Ein Sample kann aber von den bekannten Synthesizer-Modulen als Eingangssignal (anstelle der VCOs) verwendet und dann nach Wunsch verändert werden.

Das Mellotron, das in den Anfangsjahren der Popmusik auf den Markt kam, war tatsächlich ein Sampler mit Dutzenden vorgefertigter Loops, die von „echten“ Instrumenten abgenommen waren und per Keyboard gespielt werden konnten. Nicht wenige Musiker, besonders solche aus klassischen Orchestern, fürchteten schon um ihre Arbeitsplätze, weil gerade Streicher- und Bläsersätze mit dem Mellotron ziemlich perfekt gespielt werden konnten.

Damit haben wir alle Module eines Synthesizers beisammen, die der Klangerzeugung und -modulation dienen. Die meisten Module und Funktionen wurden einzeln oder in Kombinationen schon in der Analogära spielbar realisiert. Aber erst die Digitalisierung brachte die Möglichkeiten der elektronischen Musik, die wir heute kennen. Grundlage dafür: Alles, was man mit traditionellen Schaltungen, mit Röhren und Transistoren erzeugen kann, lässt sich in Form von Software nachmachen. Genau das fand ab Mitte der Siebzigerjahre statt. Und darum wird sich die dritte und letzte Folge unserer kleinen Weltgeschichte der elektrischen Musik drehen.

[Bildnachweis – Titelbild: Emerson-Moog via Synthopia.com; Röhrenoszillator via bastelnmitelektronik.de; Helmholtz-Synthesizer: via bonedo.de; Obertöne: via lernklaenge.de; Streichorchester: National Young String Orchestra; Drehorgel: moelmsche-drehorgel.de; Mellotron: ask.audio]

Kleine Weltgeschichte der elektrischen Musik – erst analog und jetzt schon lange digital (Teil 1)

Noch bis Mitte Mai zeigt der Düsseldorfer Kunstpalast die Ausstellung „Electro. Von Kraftwerk bis Techno„. Als großer Fan der genialen Band mit dem vielsagenden Namen und ehemaliger Anhänger der tanzbaren Tsing-Tsing-Mucke war ich nun schon zweimal da. Es gibt unter den mehr als 500 Ausstellungsstücken so viel zu entdecken. Die im ersten Raum nachgebauten Werkstätten und Labore der Pioniere der elektronischen Musik haben mich fasziniert. Und da dachte ich mir: Wo kommt die elektrische Musik her, wie hat sie sich entwickelt, und wo steht sie heute? Hier der erste Teil der kleinen Weltgeschichte der elektrischen Musik. Kleine Weltgeschichte der elektrischen Musik – erst analog und jetzt schon lange digital (Teil 1) weiterlesen

Digitale Denkmäler für die Ewigkeit: foreverontheblockchain.com

Ewigkeit ist ein großes Wort, manchmal ein bedrohliches, manchmal ein tröstendes. Seit Urzeiten streben Menschen die Ewigkeit an. Indem sie Bilder an Felswände malen, Pyramiden als Grabmale bauen oder Kirchen, Moscheen und Synagogen errichten. Manche Menschen wollen ihre ewige Liebe deutlich machen, indem sie sogenannte „Liebesschlösser“ an Brückengeländern anschließen. Die halten da aber nicht ewig – spätestens wenn die Brücke abgerissen wird oder die Stadtreinigung die Schlösser entfernt, ist es Essig mit der Ewigkeit. Letzteres hat den Hamburger Sven Hildebrandt zu einer verrückten Geschäftsidee inspiriert: digitale Denkmäler auf der Blockchain. Digitale Denkmäler für die Ewigkeit: foreverontheblockchain.com weiterlesen

Netflix-Serie: The Billion Dollar Code – Ist Google Earth in Wahrheit Terravision?

Diese vierteilige Netflix-Miniserie aus deutscher Produktion ist eine Sensation. Sie zeigt uns einen Kampf David gegen Goliath, ART+COM gegen Google. Und nach allem, was ich als Aktiver der IT- und Internet-Branche ab 1994 persönlich mitbekommen habe, schildern Drehbuchautor Oliver Ziegenbalg und Regisseur Robert Thalheim die Sache sehr, sehr realistisch. Kein Wunder: Ziegenbalg und sein Team haben über Jahre intensiv recherchiert, mit Dutzenden Beteiligter gesprochen (was man übrigens in einem grandiosen Making-of nachvollziehen kann) und massenhaft Dokumente und Quellen ausgewertet. Und obwohl die Namen der Protagonisten geändert wurden und eine tragende Figur hinzuerfunden wurde, fällt The Billion Dollar Code eigentlich ins Fach „fact fiction“. Netflix-Serie: The Billion Dollar Code – Ist Google Earth in Wahrheit Terravision? weiterlesen

World Wide Wahrheit? Der schmale Grat zwischen Fake und Fakten

Wie viel Wahrheit steckt im Internet, wie erkennt man Fake News, und was können Journalisten tun, um mehr Fakten sprechen zu lassen? Auf dem langen und steinigen Weg zur „World Wide Wahrheit“ geht der Digisaurier diesen Fragen nach, stellt verschiedene Faktenchecker vor und spricht mit Mirko Lange, der viel Freizeit damit verbringt, schlecht recherchierten Geschichten nachzugehen und die falschen Fakten zu korrigieren. Und wir formulieren eine Befürchtung, die mit dem Internet der Dinge zu tun hat.

World Wide Wahrheit? Der schmale Grat zwischen Fake und Fakten weiterlesen

Sensation: Endlich ein Smart Home! Das ganze Haus ist vernetzt!

So viel Smart Home, dass die Technik im Speicher des Hauses untergebracht werden muss? Nein, danke! Aber eine Sensation war es definitiv, was die Telekom vor dreizehn Jahren in Berlin präsentierte: das erste komplett vernetzte Haus. Seitdem hat sich unglaublich viel getan – nicht nur bei der Haussteuerung. Die Hersteller quetschen immer mehr Pixel in TV-Displays, einer schnallt sogar winzige Elektrofahrzeuge direkt an die Füße. Und das nennt die Branche bloß „Evolution statt Revolution“. Warum eigentlich?

Sensation: Endlich ein Smart Home! Das ganze Haus ist vernetzt! weiterlesen