Angesichts der medialen Aufmerksamkeit könnte man flapsig sagen, Algorithmen sind in aller Munde. Richtiger aber wäre zu vermelden, dass Algorithmen in allen menschlichen Hirnen und, ja, auch in den Köpfen (fast) aller Tiere stecken. Denn ganz grundsätzlich betrachtet handelt es sich bei diesen einigermaßen gehypten Dingern „eine eindeutige Handlungsvorschrift zur Lösung eines Problems“ – so beschreibt die Wikipedia den Begriff. Denn die Handlungsvorschriften können eben nicht nur in Computerprogrammen formuliert sein, sondern in menschlicher Sprache. Das beginnt schon an der Verkehrsampel. Das Problem: Jemand möchte eine stark befahrene Straße unbeschadet überqueren. Der passende Algorithmus könnte so lauten:

Vor dem Algorithmus kommt das schriftliche Rechnen

In der Schule lernen wir – ohne dass uns das bewusst wäre – im Matheunterricht nicht nur das schriftliche Rechnen, sondern eine ganze Menge an Algorithmen. Einer davon läuft unter dem Namen „Sieb des Eratosthenes„, einer Methode zum Ermitteln von Primzahlen. Aber auch der gute, alte Dreisatz ist nichts anderes als ein Algorithmus. Mittlerweile verstehen wir alle unter einem Algorithmus aber die abstrakte Form einer Handlungsanweisung zur Verarbeitung durch einen Computer.

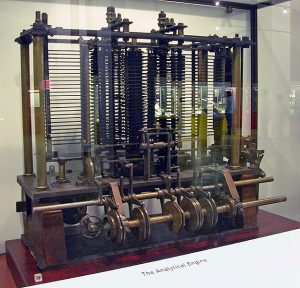

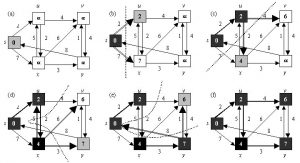

Die Pionier*innen: Ada Lovelace und Edsger Dijkstra

Algorithmen in der Künstlichen Intelligenz

Nachdem der Begriff „Künstliche Intelligenz“ lange Zeit als Hirngespinst, dann als Hoffnungsträger galt, ist die KI heute alltägliche Praxis. Wobei in der medialen Darstellung mittlerweile kaum noch zwischen vergleichsweise simplen Algorithmen wie sie jeder Informatikstudent schreiben könnte und hochkomplexen selbstlernenden Systemen unterschieden wird. Immerhin ordnet man Algorithmen, die menschliche Entscheidungsmethoden nachahmen, inzwischen der sogenannten „schwachen KI“ zu. Beispiele finden sich schon seit gut 45 Jahren in Computerspielen – die Psychiatersimulation „Elsa“ war ein frühes und relativ eindrucksvolles Beispiel. Wobei man bis weit in die Neunzigerjahre vor allem bemüht war, Programme zu schreiben, die den Turing-Test bestehen.

Daraus lernen wir: Algorithmen für das maschinelle Lernen können alles und werden immer besser in dem, was sie tun. Weil die Menschen das irgendwie und leicht irrational mit Robotern und unkontrollierbaren Systemen verbinden, macht es ihnen Angst. Und das nicht ganz zu Unrecht. Während beispielsweise der PageRank-Algorithmus, mit dem Google die Position einer Fundstelle ermittelt, (zumindest teilweise) öffentlich zugänglich und nachvollziehbar ist, hält die Schufa den Algorithmus, mit dem sie die Bonität von Konsumenten ermittelt, geheim. Mit der gemeinnützigen GmbH AlgorithmWatch gibt es mittlerweile eine Organisation, die angetreten ist, intransparente Algorithmen, die uns Bürger betreffen, öffentlich zu machen. Das wird zunehmend und besonders wichtig rund um diverse Überwachungssysteme – vom Body-Scanner am Flughafen über die Überwachungskameras im öffentlichen Raum bis hin zu den Algorithmen, mit denen Facebook & Konsorten detaillierte Personenprofile basteln.

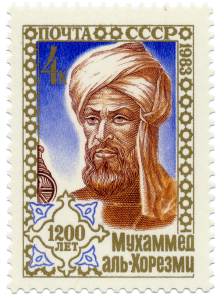

[Bildnachweis: Titelbild – via datascienceblog.pw; al-Chwarizmi via Wikimedia; Babbage-Maschine – Bruno Barral (ByB) via Wikimedia unter der Lizenz CC BY-SA 2.5; Dijkstra-Algorithmus – via Smith College, Northampton, MA; AlphaGo – via Business Insider]