Wir Digisaurier sind bekanntlich große Fans der Wayback Machine. Da kann man sich in den offiziellen Internet Archives den Zustand von Webseiten in der Vergangenheit anschauen – eine tolle Sache. Und wenn man sehen will, was eine Site aktuell zu bieten hat, ruft man sie eben auf und schaut nach. Oder nutzt eine Suchmaschine. Schwieriger wird es schon, wenn man sich – aus welchen Gründen auch immer – einen Überblick über das World Wide Web here and now verschaffen will.

Crawler sind Bots, also kleine autonom agierende Prrogrämmchen, die selbstständig durchs Web wandern und Daten sammeln. Erfunden wurden sie in den frühen Tagen des Internets. Die ersten Bots dieser Art gehörten vermutlich zu einer der ersten Suchmaschinen namens Webcrawler. Der sammelte allerdings nur Adressen, indexziert wurde zunächst manuell. Wichtigste Info, der der Webcrawler so um 1993, 1994 herum lieferte, war die schiere Größe des WWW.

Der wahre Vorläufer von Common Crawl sind aber die Internet Archives, ebenfalls eine gemeinnützige Organsation, die aber bereits 1996 gegründet wurde. Auch in diesem Fall wird das gesamte WWW gecrawlt, wobei komplette Websites eingesammelt werden. Mit der erwähnten Wayback Machine kann man das Archive nach URLs durchsuchen und sich die zugehörigen Sites zu einem bestimmten, wählbaren Zeitpunkt anschauen.

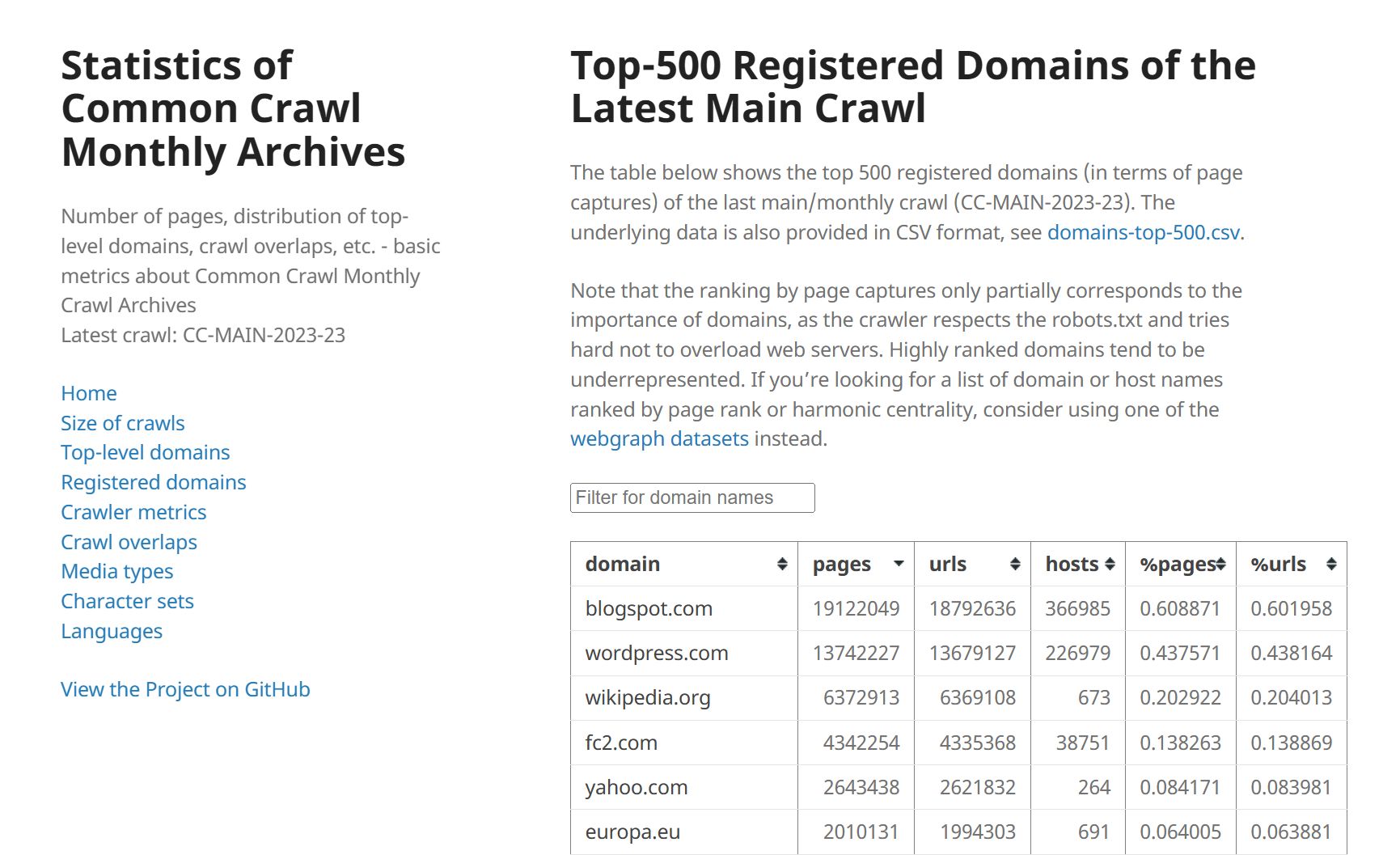

Seitdem 2013 ist Common Crawl am Start, ein gemeinnütziges Projekt, dessen Crawler wirklich das GESAMTE Internet durchstöbern und die Funde in einer einzigen Datenbank speichern. Dafür haben fleißige Entwickler das WARC-Format erfunden und dessen Struktur offengelegt. Das heißt konkret: Mit passenden Anwendungen und Programmen kann jede:r diese Datenbank durchforsten. Tatsächlich umfasst die jeweils aktuelle Datenbank ALLE öffentlich zugänglichen Texte, Bilder, Links, Metadaten und was es sonst noch an Inhalten und Informationen von und über Webseite gibt. Das sind schier unvorstellbare Datenmengen; die Größe der aktuellen Version (Stand: August 2023) liegt im hohen zweistelligen Petabyte-Bereich. Das sind Millionen Terabyte!

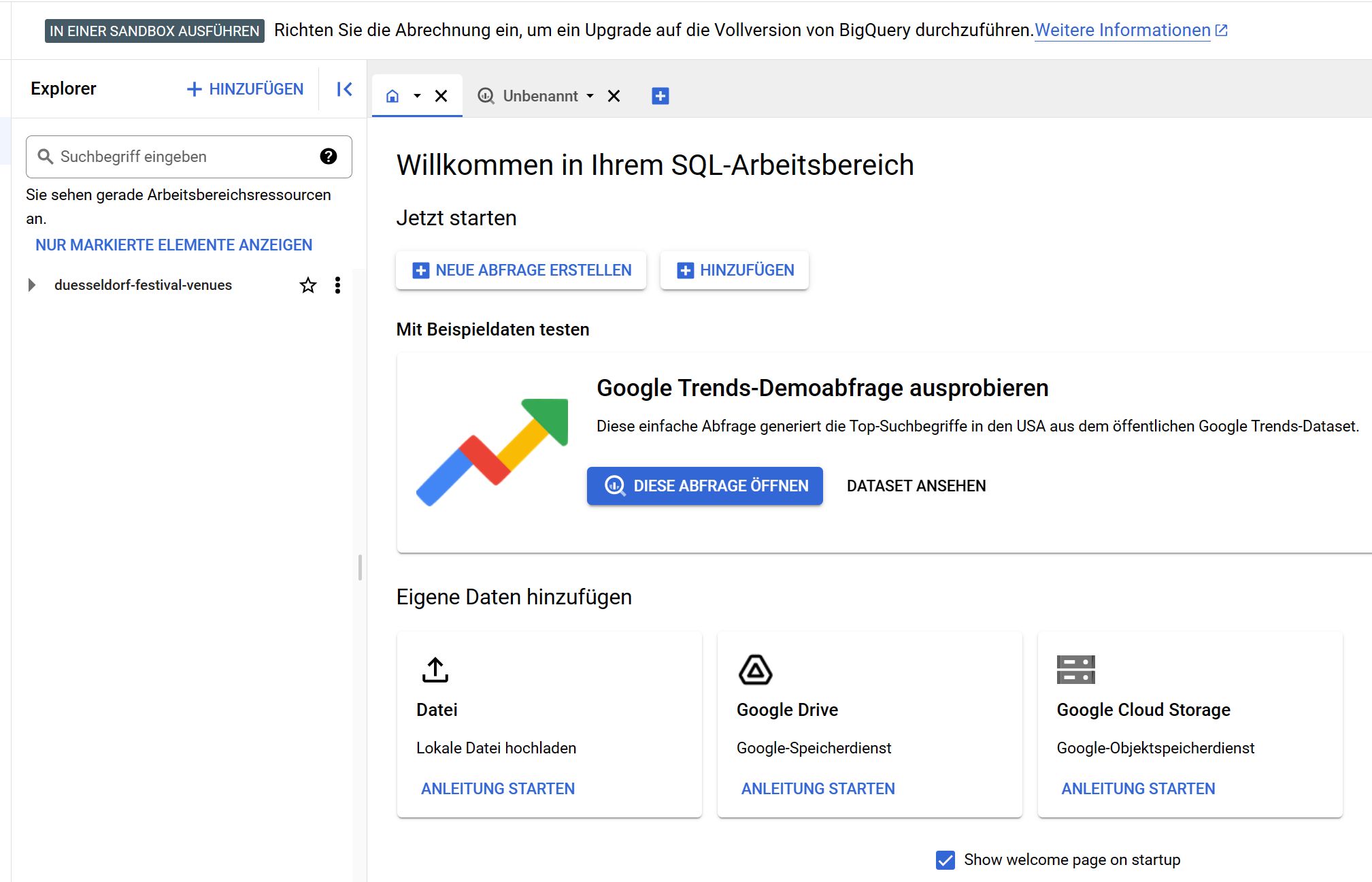

Und an dieser Stelle liegt schon ein Hase im Pfeffer, denn natürlich kann sich niemand diese irrwitzig große Datenbank einfach runterladen und zuhause mal eben analysieren. Das Projekt Common Crawl ist aber für alle, die etwas mit dem Internet zu tun haben, so eminent wichtig, dass es von einer ganzen Reihe führender Unternehmen praktisch unterstützt wird. Zum Beispiel von Amazon mit seinen Webservices namens AWS. Dort findet sich ein Service namens Amazon Athena, mit dem sich Datenbanken im Petabyte-Bereich analysieren lassen – also genau das, was für die Nutzung der Common-Crawl-Datenbank gebraucht wird.

Auch Google ist mit an Bord und stellt die nötigen Kapazitäten in seiner Cloud zur Verfügung. Außerdem wurde Gumbo, der HTML5-Parser, den Google als Open-Source-Projekt entwickelt hat, so angelegt worden, dass man mit ihm auch Daten im WARC-Format analysieren kann. Yahoo! Japan macht mit, und das erwähnte Internet Archive dient als Aufbewahrungsort gecrawlter Websites.

Aus dem Geschriebenen wird schon klar, dass es sich bei Common Crawl (im Gegensatz zur Wayback Machine, übrigens) um kein Projekt für den Rest von uns handelt. Es ist definitiv etwas für Forscher, Entwickler und Unternehmen. Die Mitglieder dieser Zielgruppen verwenden von Common Crawl gesammelten Daten:

- zu Forschungszwecken: Durch die Analyse des gecrawlten Webinhalts können Forscher und Analysten Einblicke in Trends, Muster und Verhaltensweisen im Internet gewinnen. Sie können Textanalyse, Sentiment-Analyse, Themenmodellierung und andere Techniken verwenden, um beispielsweise öffentliche Meinungen, Produktbewertungen oder soziale Trends zu analysieren.

- als Material für KI-Modelle: Der Datensatz von Common Crawl kann als Trainingsdatensatz für maschinelles Lernen und KI-Algorithmen verwendet werden. Mit den gecrawlten Webseiteninhalten können Modelle für Aufgaben wie Textklassifikation, Named Entity Recognition, maschinelles Übersetzen und vieles mehr trainiert werden.

- um Anwendungen zu entwickeln: Die Daten können für die Entwicklung von Suchmaschinen, Analysetools, KI-Anwendungen und anderen Online-Diensten genutzt werden.

- zur Untersuchung rechtlicher und gesellschaftlicher Fragen zu untersuchen: Die archivierten Daten können dazu verwendet werden, rechtliche oder soziale Themen wie Meinungsbildung, Desinformation oder öffentliche Meinung zu untersuchen.

- für die Website-Analyse und SEO-Optimierung: Unternehmen können Common Crawl verwenden, um Informationen über ihre eigene Website und die Wettbewerber zu erhalten. Durch die Analyse von Metadaten, Seitentiteln, internen Verlinkungen und anderen Faktoren können Unternehmen Einblicke gewinnen und ihre SEO-Strategie verbessern.

- für die Verbesserung der Internet-Sicherheit: Common Crawl kann auch für die Überwachung von Sicherheitslücken und Bedrohungen im Internet eingesetzt werden. Durch das Crawlen und Analysieren von Webseiten können potenziell bösartige Inhalte, Phishing-Websites oder andere Sicherheitsbedrohungen identifiziert werden. um Inhalte zu bewahren: Common Crawl trägt zum Erhalt der digitalen Geschichte bei, indem es eine umfassende Datenbank mit Internetinhalten aufbaut.

Sollen Inhalte untersucht werden, können alle geeigneten HTML-Parser, die das WARC-Format verstehen, auf die Datenbank losgelassen werden. Weil die Schnittstellen bekannt sind, lassen sich aber auch in allen gängigen Programmiersprachen Tools für ganz besondere Aufgaben selbst schreiben – entsprechende Bibliotheken gibt es bereits für Python.

Fazit

Wer wirklich wissen will oder wissen muss, was gerade im Internet passiert, findet im Common-Crawl-Projekt die geeignete Quelle. Gerade die großen Mitspieler im Web und die bekannten Unternehmensberatungen nutzen diese Datenbank bereits intensiv und beschäftigen Spezialist:innen, die auf Anfrage nahezu jede valide Information über das gesamte Web, Ausschnitte davon oder einzelne Websites ermitteln. Der einzige Bereich, der von Common Crawl nicht durchwühlt wird, ist das sogenannte „Deep Web“ (früher auch „Darknet“ genannt). Was sich dort abspielt, lässt sich mit den üblichen Methoden nämlich nicht crawlen.