Das Blöde am technischen Fortschritt ist doch, dass mühsam erworbene Verständnis für eine Innovation regelmäßig durch Revolutionen überholt wird. So um 1986 herum haben wird doch gedacht: „Okay, das geht jetzt immer weiter so: auf 80286 folgt 80386, dann 80486, 80586 und so weiter.“ Aber es kam anders, denn schon 2005 waren die grundlegende Design-Philosophie und die bekannten Herstellungsprozesse am Ende; die Geschichte der Mikroprozessoren trat in eine neue Ära ein. Heute ist es um ein Vielfaches einfacher und kostengünstiger eine CPU für digitale Maschinen zu entwickeln und zu fertigen. So musste Intel noch einen zweistelligen Millionen-Dollar-Betrag in den 80386 investieren, und der Prozessor kostete zu Beginn beinahe 1.000 US-Dollar.

Natürlich liegt die Ursache vor allem darin, dass Computer die Hauptarbeit beim Chip-Design übernehmen und dass es seit gut zwölf Jahren KI-artige Software gibt, die aus den definierten Spezifikationen einen Basisentwurf macht. Das war um das Jahr 2000 noch schier unvorstellbar. Die entscheidende Idee (wem sie kam, ist nicht klar herauszufiltern) war es, mehrere Mikroprozessoren in einer CPU zu vereinen, also zwei, vier oder mehr Rechenkerne auf einen Chip zu packen. Bis zum Intel 80386 versuchten die Ingenieure die generelle Leistungsfähigkeit durch immer höhere Taktfrequenzen und neue Befehlssätze zu erhöhen.

Wie jeder weiß, der es mal mit dem Übertakten der alten CPUs versucht hat, bringt die höhere Taktfrequenz mehr Hitze, die dem Gesamtsystem Schaden zufügen kann, wenn man nicht für Kühlung sorgt. Die Klimaanlage für Hochtakter verbraucht Strom, die Beschleunigung des Mikroprozessors ebenfalls. Und damit eine klassische Einkern-CPU höher getaktet werden kann, muss sie deutlich präziser gefertigt sein, was den Prozentsatz an unbrauchbaren Prozessoren in der Fertigung dramatisch steigert. Mit den RISC-Prinzipien, also der Entwicklung von reduzierten Befehlssätzen und solchen, bei denen Instruktionen parallel auf verschiedene Daten und Operationen angewendet werden können, ließ sich noch ein bisschen mehr Leistung aus den ollen Dingern pressen.

Die Ansprüche an die zentralen Recheneinheiten von Computern waren um 1995 herum schneller gewachsen als die Leistungsfähigkeit der Mikroprozessoren. Die Hersteller von Hochleistungs-PCs und Workstations gingen in dieser Phase einen anderen Weg als den auf bessere CPUs zu hoffen. Für immer mehr Funktionen – vor allem im Bereich der Grafik-, Bild-, Foto- und Videobearbeitung, aber auch bei allem rund um den Sound – übernahm man ein relativ altes Prinzip, das Commodore beim Amiga in den Achtzigerjahren bereits erfolgreich eingesetzt hatte: Man entwickelte spezielle Prozessoren für spezielle Aufgaben, also Mikrochips, die wirklich nur Pixel besonders schnell verschieben können oder ähnliche Inselbegabungen hatten. Otto Normal-PC-User bekam davon um die Jahrtausendwende wenig bis gar nichts mit.

Das änderte sich schlagartig mit der Ankunft des Smartphones. Schon in einem frühen Stadium der Arbeiten am iPhone, also so um 2004 herum, war den Apple-Leuten klargeworden, dass an die CPUs mobiler Geräte völlig andere Anforderungen zu stellen waren. Erstens mussten diese klein sein, zweitens enorm leistungsfähig, drittens durften sie nicht zu heiß werden und viertel nicht zu viel Strom verbrauchen. Die einzige Lösung war die ARM-Architektur, ja, genau die der RISC-Chips, die von den britischen Computerpionieren bei Acorn 1983 vorgestellt worden war und die bis dahin lediglich beim Bau proprietärerer CPUs für Highend-Grafik-Workstations angewendet wurde! Ohne Acorn kein ARM, ohne ARM keine brauchbaren Smartphone-CPUs – so ist es.

Intel hatte schon beim 80386 auf RISC-Prinzipien gesetzt, aber immer versucht, sie auf ihr bewährtes, seit dem 8086 wenig veränderten Grundentwurf anzuwenden. Kein Wunder, folgte man dort doch den Gedanken des Mitgründers Gordon Moore und seinem Moore’schen Gesetz. Danach ging es immer nur darum, die Anzahl ICs auf einer gegebenen Fläche zu erhöhen; sein Gesetz von 1965 besagt, dass die Integrationsdichte sich alle 24 Monate (manchmal heißt es auch „alle 12 Monate“) verdoppelt, wobei die Kosten sich halbieren. Diese Regel stammt aus den Sechzigerjahren als es noch darum ging, möglichst viele Prozessoren auf eine möglichst kleine Platine zu bekommen.

Aber schon Ende der Achtzigerjahre war klar, dass diese galoppierende Miniaturisierung an ihre Grenzen stoßen würden. Bekanntlich werden die Matrizen für einen Chip auf lithographischem Wege erzeugt; irgendwann sind aber die erforderlichen Strukturen mit sichtbarem Licht so nicht mehr mit ausreichender Fehlerlosigkeit darstellbar. Also griff man zur Röntgenlithographie, aber auch deren Grenzen wurden schnell sichtbar. Das Rennen um noch höhere Integrationsdichte war so um 2008 herum gelaufen – Einkernprozessoren waren bei etwa 100 Millionen Transistoren angekommen, die Fertigungstechnik so weit optimiert, dass sie zu vernünftigen Preisen hergestellt werden konnten.

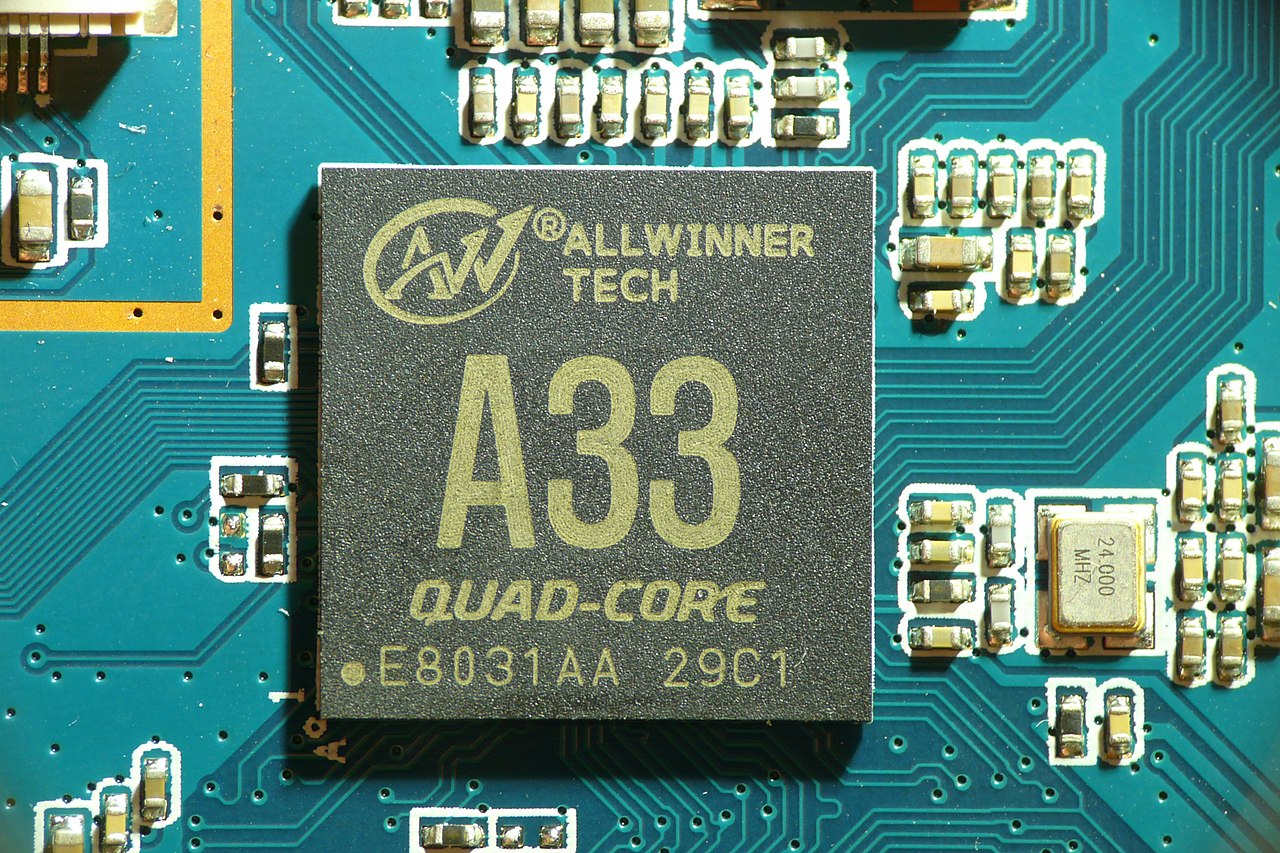

Während die Großen der Branche, namentlich Intel und AMD, auf dieser Schiene weiterarbeiteten und sich auf die Mehrkerntechnologie warfen, gingen asiatische Computerkonzerne einen anderen Weg und begannen SoCs (System On a Chip) zu designen und zu fertigen. So kam es dazu, dass die Zentraleinheit der ersten Generation iPhone von Samsung stammte. Es war der S5L8900, dessen Architektur bis heute quasi die Blaupause für alle SoCs in Smartphones bildete. Die Idee der SoC-Philosophie ist grundsätzlich, eine CPU und die Baugruppen für die speziellen Funktionen auf einem Chip zu integrieren und dabei ICs ganz unterschiedlichen Typs zu verwenden.

Genauso einschneidend wie diese rein technologische Evolution war die Art und Weise wie diese Chips entworfen werden. Ab Anfang der Nullerjahre sind weltweit eine Menge kleiner Ingenieurbüros entstanden, die sich auf das Design solcher SoCs für Smartphones spezialisiert und den Prozess der Entwicklung teilweise automatisiert haben. Gab es bei Intel, Motorola und Co. noch entsprechende Inhouse-Abteilungen, haben die Hersteller dieser Chips diese Aufgaben ganz oder teilweise outgesourct oder Teiljobs sogar auf mehrere Anbieter verteilt. Auf diesem Wege sind neue Hersteller wie Qualcomm (Snapdragon-Serie) oder MediaTek zu Weltkonzernen gewachsen, während einige Smartphone-Companys wie Huawei (Kirin-Serie) und Samsung (Exynos-Serie) auf Eigenentwicklungen setzen – wie neuerdings Apple auch.