In den Achtzigern gingen viele Experten davon aus, dass sich der Homecomputer ähnlich entwickeln würde wie das Auto. Und lagen damit gar nicht falsch. Wobei besonders in den Neunzigern so etwas wie eine Tuning-Szene entwickelte. Ambitionierte Nutzer:innen versuchten nämlich, das Letzte aus ihren Kisten herauszuquetschen. Das betraf nicht nur die schiere Geschwindigkeit, sondern auch das leidige Thema Speicherplatz – auf den sogenannten Speichermedien. Während das Übertakten noch heute ein Thema bei Gamern ist, geriet das Komprimieren von Daten in Echtzeit beim Speichern auf der Festplatte in Vergessenheit.

Gut, nur ganz Mutige setzten vor dem Jahr 2000 ihren Rechner für die Bildbearbeitung ein, schon gleich gar nicht für das Editieren und Schneiden von Videos. Schließlich waren die ersten Digitalkameras gerade erst auf dem Markt, und Scanner zum Digitalisieren von analogen Fotos nicht besonders weit verbreitet. Aber die Grafik an und für sich war schon ein Thema. Farbige Bilder waren (und sind) allerdings um ein Vielfaches größer als beispielsweise Textdateien. Da waren die für heutige Verhältnisse winzigen Festplatten – erst um 2000 herum konnte sich Otto Normaluser eine Harddisk im Gigaybyte-Bereich leisten. Mein erstes Apple-Powerbook verfügte über eine 10-MB-Platte – da wurde es allein schon eng, wenn viel Text zu speichern war.

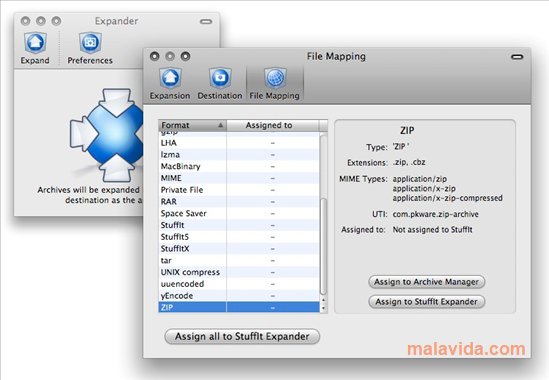

Die Datenkomprimierung war allerdings auch schon erfunden. Heute haben sich Standards wie ZIP durchgesetzt, damals konnte man aus Dutzenden Tools wählen, die durch mehr oder weniger geschickte Algorithmen aus großen deutlich kleinere Dateien machten. In der Mac-Welt hatte sich StuffIt weitgehend durchgesetzt. Der Clou: Das Hilfsmittel arbeitete in Echtzeit; das heißt, dass jede Datei bei jedem manuellen und auch automatischen Zwischenspeichern komprimiert werden konnte. Das war Segen und Fluch zugleich, denn wenn StuffIt aus irgendeinem Grund nicht mehr funktionieren wollte, kam man an die gespeicherten Daten einfach nicht mehr dran. Genau das passierte mit der erwähnten 10-MB-Festplatte im Powerbook, auf der noch heute Texte lagern, die ich herzlich gern mal wieder ausgepackt hätte.

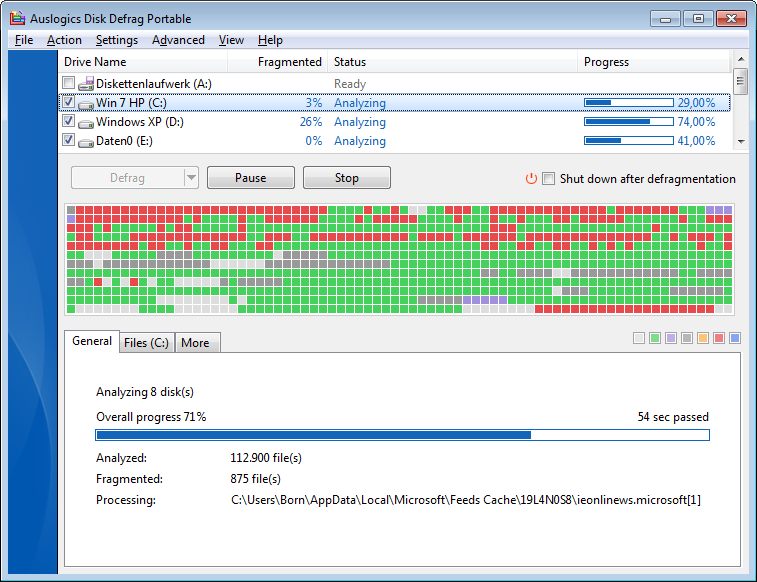

Die Funktion, den aufgrund der Aufzeichnungsmethodik verschwendeten Speicherplatz auf einer Harddisk verfügbar zu machen, gab es in der DOS-Welt schon vor Windows. Auch diese Fähigkeit fällt unter das Stichwort „Datenkomprimierung“. Zum Umfang der damals beliebtesten DOS- und Windows-Tools – zum Beispiel aus dem Hause Norton – gehörten Werkzeuge, die noch weiter gingen und den Speicherplatz optimierten, indem fragmentierte Dateien zusammengefasst und oft benötigte Daten an den physikalischen Anfang der Platte gelegt wurden. Weil bei dieser Optimierung ernsthaft Datenblöcke hin und her geschaufelt wurden, dauerte die Arbeit oft Stunden. Und leider ging auch mal etwas schief, man verlor Dateien. Vom ganzen Thema ist heute nur noch das Komprimieren von sehr großen Datenmengen übrig, die per Upload oder USB-Stick an jemand anderen weitergegeben werden sollen.

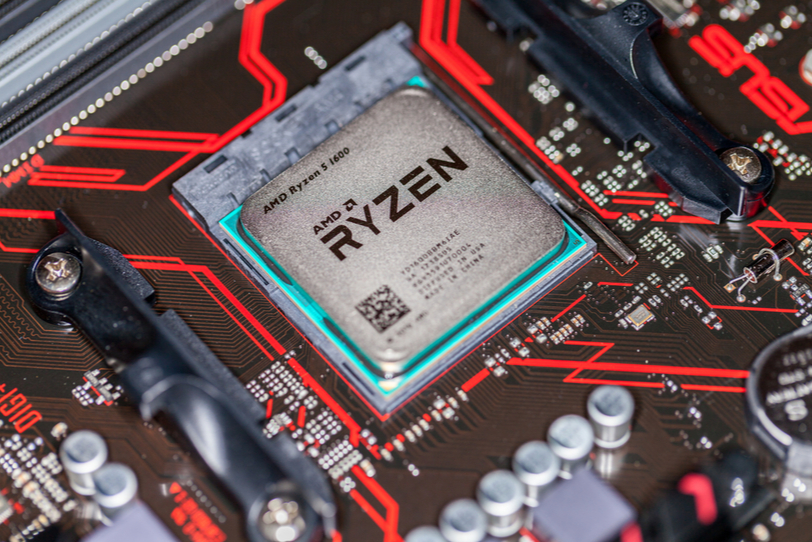

Jahrelang wurde in der PC-Szene über Taktfrequenzen debattiert. Dieser Takt bestimmt, wie schnell Daten innerhalb des Bussystems eines Rechners transportiert werden, und betrifft deshalb nicht nur die CPU, sondern unter anderem auch die Grafikkarte und letztlich die Arbeitsgeschwindigkeit des ganzen Systems. Einen PC zu mehr Speed zu verhelfen, besteht als darin, die Taktfrequenz(en) zu erhöhen – man nennt das „Übertakten“ oder auf Englisch „overclocking“ (kurz: OC).

Technisch gesehen ist ein „Takt“ ein durch einen internen Oszillator synchronisierter Puls, aber zu unseren Zwecken ist das eine grundlegende Einheit, die uns hilft, die CPU-Geschwindigkeit zu verstehen. In jedem einzelnen Zyklus werden mehrere Milliarden von Transistoren im Prozessor geöffnet und wieder geschlossen. [Quelle: Intel]

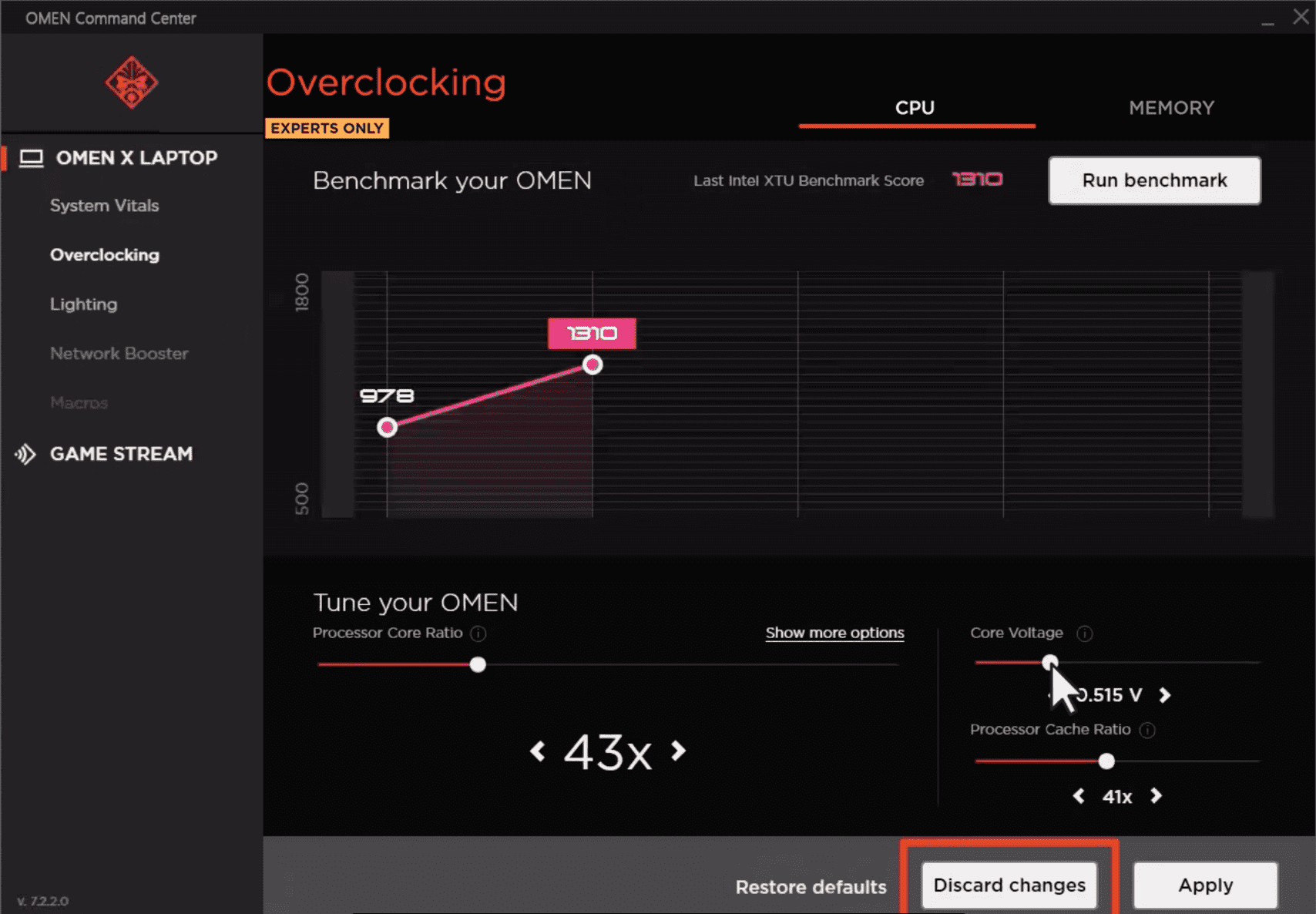

Wie schnell die CPU läuft, wird vom BIOS bzw. UEFI vorgegeben und kann mit eventuell verfügbaren Tools des jeweiligen Motherboard-Herstellers oder direkt bei den BIOS- bzw. UEFI-Einstellungen (in der Regel in der „Advanced“-Abteilung) in gewissem Umfang verändert werden. Das CPU-Overclocking beruht auf der Tatsache, dass diese Chips vom Hersteller so niedrig getaktet werden, dass ihre Funktionsfähigkeit nicht beeinträchtig wird. Damit will man Qualitätsschwankungen bei der Herstellung ausgleichen. Denn: Ein höherer Takt bedeutet eine höhere Temperatur. Und je nachdem, wie gut schon die Silizium-Wafer sind, halten die Prozessoren mehr oder weniger Hitze aus. Die Hersteller der Motherboards richten sich nach den Empfehlungen der CPU-Erzeuger, bieten aber auch Takte an, die an den Grenzen der CPU-Spezifikationen kratzen. In aller Regel bringt das Ausreizen dieser Grenzen keine spürbare Erhöhung der Arbeitsgeschwindigkeit des Gesamtsystems.

Also muss man mit schwererem Gerät an die Sache gehen und die Taktung mit sehr speziellen Methoden noch weiter erhöhen. Außerdem muss der Prozessor dann ausreichend gekühlt werden; was der normale Lüfter leistet, reicht da nicht aus. Freaks, die aus reinem Spaß an der Freud‘ an diesem Thema arbeiten, arbeiten deshalb bei ihren übertakteten Systemen gern mit Wasserkühlung oder setzen sogar Flüssigstickstoff ein. Aber das Overclocking bringt nicht nur ein Wärmeproblem mit sich; übertaktete System können sich regelrecht verschlucken und zu Rechenfehlern auf Maschinenebene führen. Weil die Betriebssysteme solche Fehler aber so weit möglich durch Neuberechnungen zu korrigieren trachten, können Computer mit überhöhter Taktfrequenz am Ende sogar langsamer arbeiten als nicht getunte.

Eine Wissenschaft für sich, die gerade in den vergangenen fünf, sechs Jahren wieder ins Gespräch gekommen ist, gilt dem Übertakten von Grafikkarten. Jenseits der integrierten Grafik-Chips in Notebooks und Tablets öffnet sich die Welt der Highend-Grafiksysteme – ursprünglich im Interesse von Gamern entwickelt, inzwischen aber besonders beim Mining von Kryptogeld von Bedeutung. Im Grund sind „Grafikkarten“ dieser Sorte nichts anderes als hochspezialisierte Computer, die als One-Trick-Ponies nicht anderes können, als Grafikdaten in atemberaubender Geschwindigkeit zu berechnen und ans Display zu schicken. Solche Systeme besitzen dafür eine CPU, und die kann natürlich auch einem OC-Prozess unterzogen werden.

Weil das Übertakten für den Rest von ins mittlerweile keinen Sinn mehr macht und die gängigen Computer ohnehin schnell genug sind, ist das Overclocking außerhalb der beschriebenen kleinen, radikalen Minderheit zum verlorenen Wissen geworden.